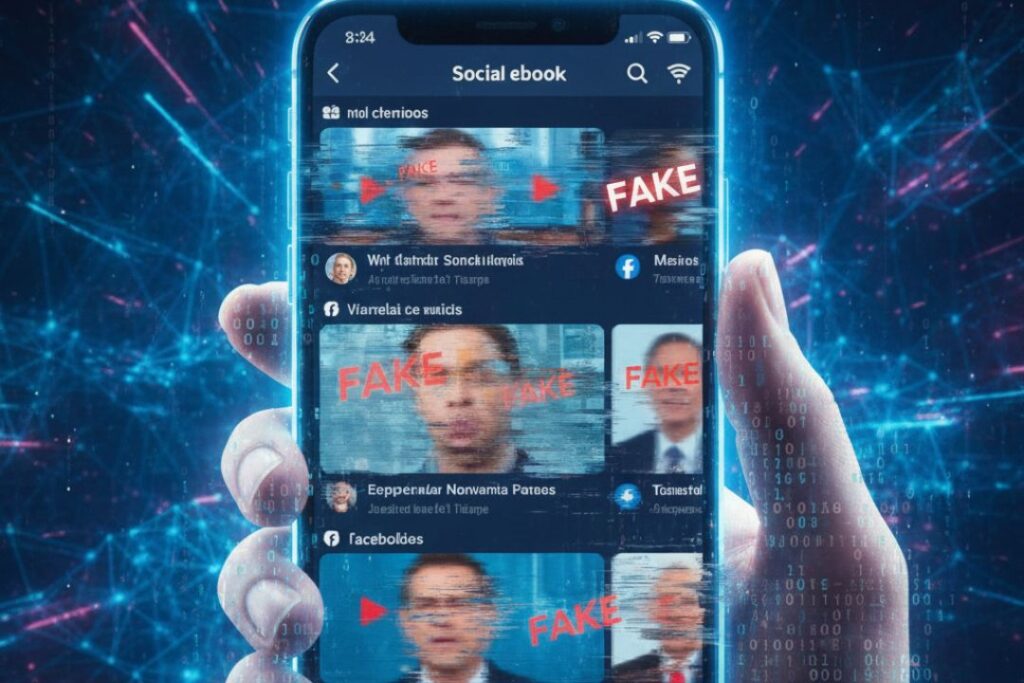

Desde el lanzamiento de Sora, la herramienta de generación de video de OpenAI, las redes sociales se han llenado de contenido hiperrealista creado con inteligencia artificial. La aplicación alcanzó cerca de un millón de descargas en menos de cinco días tras su última actualización de septiembre, lo que volvió tan sencillo producir videos falsos como escribir unas líneas de texto.

Uno de los casos más comentados ocurrió en octubre, cuando en TikTok se difundió un video fabricado que mostraba a una mujer hablando sobre la venta de cupones de alimentos por dinero en efectivo durante una supuesta entrevista televisiva. Aunque el clip tenía señales claras de origen artificial e incluso una marca de agua de Sora que luego fue cubierta por quien lo publicó, miles de usuarios lo tomaron como real y reaccionaron con condenas cargadas, en algunos casos, de racismo abierto.

Expertos alertan sobre el impacto democrático

Para especialistas en seguridad digital, esta avalancha de videos generados por IA abre una etapa especialmente peligrosa en debates públicos sensibles, como los relacionados con programas de asistencia gubernamental. El académico Hany Farid advirtió que la ciudadanía se expone cada día a una cantidad desconocida de este tipo de contenidos y que eso representa un riesgo para la democracia, la economía y las instituciones, al erosionar la confianza en lo que se ve en pantalla.

Casos como el del video de cupones ilustran lo fácil que resulta que una pieza creada con IA se convierta en prueba “visual” dentro de discusiones políticas polarizadas, incluso cuando su falsedad puede detectarse con un análisis cuidadoso cuadro por cuadro.

Plataformas rebasadas y marcas de agua inútiles

Grandes compañías de redes sociales como Meta, TikTok, YouTube y X ya cuentan con reglas que obligan a etiquetar contenido generado por IA, pero en la práctica estos lineamientos se quedan cortos. La marca de agua de Sora, diseñada para ayudar a identificar videos artificiales, puede borrarse en segundos con herramientas gratuitas disponibles en línea; basta buscar “sora watermark” para encontrar múltiples servicios que ofrecen su eliminación.

Sam Gregory, director de la organización de derechos humanos WITNESS, subrayó que la responsabilidad principal recae en las empresas tecnológicas. Aseguró que podrían mejorar de forma notable la moderación de desinformación y contenido engañoso, así como reforzar las medidas proactivas para detectar y etiquetar videos generados por IA, pero hasta ahora no han estado a la altura del desafío.

Te puede interesar:

Casos en Facebook y medios tradicionales

La vulnerabilidad de las plataformas queda en evidencia con lo que ocurre en Facebook, donde circulan videos de presentadores de noticias creados con IA y supuestos arrestos que nunca sucedieron, sin advertencias ni señales claras de que son montajes. Muchos usuarios comentan estas publicaciones como si se tratara de imágenes auténticas, lo que amplifica su alcance y refuerza narrativas falsas.

Incluso medios tradicionales han caído en la trampa. Fox News llegó a difundir una nota en la que presentaba como reales a beneficiarios del programa SNAP generados por IA. Solo después de que la audiencia señalara que las imágenes eran fabricadas, el canal corrigió su cobertura, evidenciando que ni siquiera las redacciones profesionales están inmunes al engaño cuando se enfrentan a videos hiperrealistas producidos con herramientas como Sora.

Este tipo de análisis resulta especialmente útil para audiencias digitales que consumen noticias en tiempo real y exigen explicaciones claras sobre los riesgos de la desinformación impulsada por IA.

Gobierno federal igual es afectado

El propio Gobierno de México ha tenido que salir a desmentir videos creados con inteligencia artificial que difunden historias falsas sobre la presidenta Claudia Sheinbaum, como el supuesto programa Bono Mujer o Bono Violeta de 2,500 pesos para mujeres de 18 a 63 años, y la versión que la presenta como dueña de una concesionaria de autos.

En ambos casos se aclara que no existen esos apoyos oficiales y que dichos contenidos buscan engañar a la gente y obtener sus datos personales mediante formularios fraudulentos, lo que confirma cómo los videos generados por IA se usan para estafas y campañas de desinformación política.

El video también desmiente otras narrativas falsas que se viralizaron en redes, como que el SAT no tiene dinero para devolver saldos a favor o que el gobierno anterior dejó de combatir el tráfico de fentanilo, aportando cifras de declaraciones revisadas, devoluciones realizadas y aseguramientos récord de esta droga, además de la captura de productores relevantes.